Computer Music & Horror Vacui

udo matthias drums electronic software – afrigal Binzen Basel

_____ _____ .__ .__

/ _ \_/ ____\______|__| _________ | |

/ /_\ \ __\\_ __ \ |/ ___\__ \ | |

/ | \ | | | \/ / /_/ > __ \| |__

\____|__ /__| |__| |__\___ (____ /____/

\/ /_____/ \/

Computer Music – MAXMSP – M4L – Chuck – Sounddesign – Reaktor – modular – horror vacui

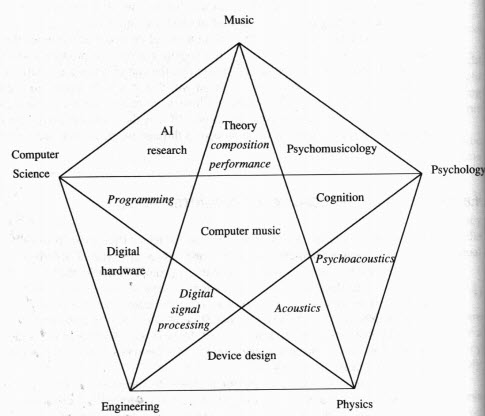

Der Begriff horror vacui geht auf Aristoteles (Physik, Kapitel IV 6–9.) zurück, der mit horror vacui (griechisch: kenophobia) das Phänomen bezeichnete, dass die Natur kein Vakuum kenne. In die Kunst übertragen, wurde der Begriff zum ersten Mal von dem italienischen Kunstkritiker Mario Praz verwandt, der damit vor allem überladene Werke viktorianischer Kunst beschrieb. Auch für die Fülle und den Prunk des Barocks wird der Begriff verwendet https://www.musicainformatica.it/ascolta/aa-vv-computer-music-from-the-outside-in.php Computermusik

ist Musik, zu deren Entstehung die Verwendung von Computersystemen notwendig oder wesentlich ist.

https://www.youtube.com/watch?v=yxDQSluWaMs https://www.youtube.com/watch?v=9w71MmB-1VU

Fortran war meine erste Computersprache, die ich lernen musste/durfte, später Basic, dann Pascal, dann C++ und Assembler…………………irgendwann Supercollider…MAXMSP,

JAVA als OOP,OOA…

Hubert Kupper: Computer und musikalische Komposition. Braunschweig 1970 Curtis Roads: The Computer Music Tutorial. MIT Press 1996 Martin Supper: Computermusik. in: MGG – Die Musik in Geschichte und Gegenwart. Allgemeine Enzyklopädie der Musik. Kassel 1995, Sp. 967–982 André Ruschkowski: Soundscapes – Elektronische Klangerzeugung und Musik, 1. Auflage 1990 Elektronische Kangmusik ist Musik ist Musik, die aus elektronisch erzeugten Klängen besteht.

https://www.youtube.com/watch?v=JzY12n5VvPE

Udo Matthias drums electronic software Schlagzeugunterricht Binzen

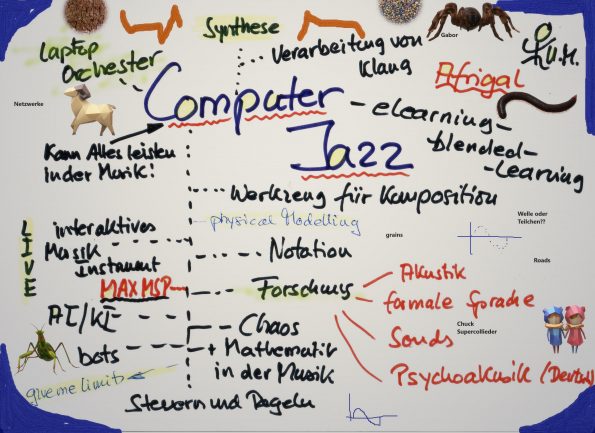

Was ist Computer Assisted Jazz und elektronische Klangmusik?

Computer Assisted Jazz & Ambient JAZZ

hat mich über meine Ausbildung schon immer bewegt und angesprochen, genauso wie mathrock, freie improvisation (Komplexitätstheorie und Chaosforschung), das Art Ensemble und natürlich. https://www.youtube.com/watch?v=8m-KlgF48mU Blues. Blues ist alles, denke ich!! 😉 🙂 Chuck, Programming on the Fly, Hardwareansprache,Pure Data, Max, Ableton, parallel Processing,Musik Ästhetik, interaktive Verwendung neuer Medien, Klang und das Malen mit Klängen, Neue Musik usw. usw. s.a. unter Electronic Unendliches Spiel DEGEMOhne ihn gäbe es diesen Bereich in der Schweiz wahrscheinlich gar nicht. Bruno Spörri Ambient JAZZ – Variante der elektronischen Musik Eigene Versuche Unsere westliche Kunstmusik hat der Benediktinermönch Guido von Arezzo wesentlich beeinflusst mit der Erfindung der Notenschrift in einem Terzsystem. Wegen Anfeindnungen musste er damals das Kloster verlassen. Er hatte ja die mündliche Tradition der Überlieferung von Gregorianischen Chorälen, also eine Geheimwissenschaft untergraben. Unsere digitale Revolution lässt sich hier gut vergleichen. Heute wie damals bildet sich ein neues Medium der Komposition aus.

In einer digitalen Musikkultur findet der Kompositionsprozess nicht länger im Medium von Noten, sondern auch im Medium von Samples statt- was auch eine neue Aufführungspraxis nach sich zieht. Für mich sind beide Welten nachvoll ziehbar. Ich würde mich einer neuen Möglichkeit entziehen, würde ich das Rad immer wieder neu erfinden wollen und somit der eigenen Kreativität unnötige Grenzen setzen!!!

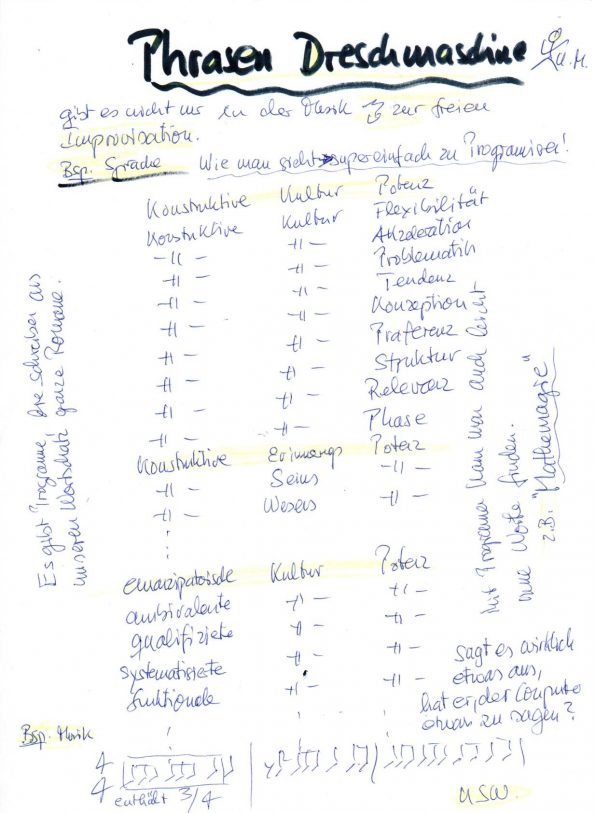

Ob im Musikverlag, im Ensemble, in der Musikhochschule in allen drei Säulen der Musik gibt es Erosionserscheinungen der Institutionen. Materialstand der Gegenwartsmusik beinhaltet Klang als Mittel des Kompositionen. Das impliziert einen sehr großen Pool an Klangmaterial Kritiker sagen: Eine Computerkomposition gelange bestenfalls zu einem Mischergebnis einer kunstlosen Musik mit Musik! Vor 100 Jahren: Vor gut hundert Jahren formulierte Filippo T. Marinetti sein erstes Futuristisches Manifest einer neuen Maschinenkunst. Es sollte aber hundert Jahre dauern, bis die technischen Möglichkeiten auch einen qualitativen Quantensprung erahnen lassen. An dem Punkt der „Qualität“ scheiden sich nun die Geister. Und: Erschlägt das Konzept die Idee oder geht letztere im ersten auf… Komposition, musikalische Praxis und musikalische Wahrnehmung stehen an einem Scheideweg. Die rasche Entwicklung der digitalen Welt samt ihrer Vernetzung wird für die musikalische Kreation nicht folgenlos bleiben. Zu lange Zeit war es still um musikästhetische Differenzen in neuer Musik. In der vorliegenden grundsätzlichen Kontroverse werden nun überfällige und drängende Fragen an die Zukunft neuer Musik gestellt und teils polemisch ausgefochten. (Kreidler/Lehmann) Heute: Kompositionsprogramme und Informatik ermöglichen es Stücke aufzuführen, die sonst keiner technisch spielen kann. Absolut unspielbares wird spielbar. Bsp: altes Selbstspielklavier – abstruse Tastenkombinationen – Conlon Nancarrows – Studies for Player-Piano – Frank Zappa Heute kann man auch Stücke aufführen, die technisch so hochkompliziert sind, ohne dass ein Instrumentalist / Musiker zum Höchstleistungsportler deklariert wird. Was der Musiker nicht spielt oder spielen will, spielt die Klangmaschine. z.B. 3-4 Stimmen, die ein Computer/Laptop spielt und 2-3 Stimmen für die Musiker. Der Musiker kann sich also wieder auf sein wesentliches konzentrieren, nämlich Musik gehaltvoll zu spielen, was seine eigentliche Kunst ausmacht. Sowie der Photoshop eine Menge änderte, so wird es bald einen Soundshop oder so etwas Ähnliches geben. What happens in yourself by listening to a song!! Vollkommen computergenerierte Musik. Früher: Iannis Xenakis – Gendy 3 – Idee der automatisierten Kunst – von einem Kompositionsautomaten komponiert Heute: Pc- Laptop und Internet Musikalische Objekte und Prozesse werden bald zur Verfügung stehen. Schon die Begriffe verweisen eindeutig auf das Objektorientierte Denken der Informatiker. – Lachenman’sche Geräuschfelder Energy of Sounds (Elvin Jones) – What happens in yourself!! – Ferneyhough‘sche Texturen – Grisey’sche Spektralakkorde Spektral Musik Die Spektralmusik ist nicht von der mathematischen Reihung von (Ton-)Parametern der seriellen Musik oder der freien Konstruktion der atonalen Musik geprägt, sondern beruht auf den Obertönen der Klänge. Man unterscheidet zwischen zwei Arten von Spektren: Harmonischen und inharmonischen Spektren. Ein harmonisches Spektrum basiert auf der Obertonreihe. Unter einem inharmonischen Spektrum versteht man alle Arten von Spektren, die beispielsweise Geräuschen zugrunde liegen. Ein Beispiel für die Komposition eines harmonischen Spektrums ist der Beginn des Werks „Partiels“ von Gérard Grisey oder das Werk „In Vain“ von Georg Friedrich Haas. Ein inharmonisches Spektrum kann zum Beispiel eine Computeranalyse mit Audiosculpt oder Spear von einem Geräusch sein. Ein Beispiel für inharmonische Spektren ist das Werk „Winter Fragments“ von Tristan Murail. In diesem wird ein TamTam Schlag synthetisiert und per MIDI Keyboard als Sample abgerufen und instrumentiert. Dieses analysierte Spektrum kann dann beispielsweise harmonisiert oder synthetisiert werden, ist also sowohl von einem Ensemble oder Orchester spielbar, als auch von einem Synthesizer. Generell benutzen Spektralkomponisten Annäherungen an das Spektrum, in dem sie Viertel- oder Achteltöne notieren Das Innenleben der Klänge Für das Komponieren mit dem Computer gilt mehr als sonst wo José Ortega y Gasset’s Aussage: Technik ist die Anstrengung, sich Anstrengungen zu ersparen! Ingenieure und Informatiker arbeiten mit Objekten und parallelen Prozessen, Algorithmen und Datenbanken im Bereich der AI/KI und können heute problemlos Kompositionsprogramme und anderes verwirklichen. Die Musik ist die technischste unter den Künsten. Für mich ist die interessanteste Aufgabe für einen guten Künstler, das Komplexe so zu vereinfachen dass es ein jeder versteht, bzw. nichts mehr von der Komplexität merkt, weil alles locker und rund in sich selbst wirkt. Das hat mit Spiritualität und Marxismus zu tun. Jazzmusiker reden schon immer gerne von Spiritualität und nicht von Religösität, weil sie an Institutionen haftet. Heilige Hallen sind ein Abscheu für mich. In meinem Verständnis des Blues, Jazz und Rock ist eine Entakademisierung gleichbedeutend mit Freiheit und der Revolution des Internets. Amateure ohne Ausbildung, Studienabbrechen, Spätberufene und Quereinsteiger werden sich, dank der technischen Entlastung, die der Laptop mit sich bringt, als Komponisten profilieren! (Quellen: Netz + Kreidler). Jazz ist die Freiheit viele Formen zu haben. (Duke Ellington) Roxy Music Brian Eno Tony Buck Hans Deyssenroth Lörrach 1983 Seit 43 Jahre mein Freund und auch musikalischer Begleiter und Berater aus München „Karl Friedrich Gerber„ Eigenklang Elektronik und Synths Laptop Orchester Einer meiner Lieblinge!! Ge Wang Links:

„Informationstheorie und

Computermusik“

Informationstheorie und Musik

- Hubert Kupper: Computer und musikalische Komposition. Braunschweig 1970

- Curtis Roads: The Computer Music Tutorial. MIT Press 1996

- Martin Supper: Computermusik. in: MGG – Die Musik in Geschichte und Gegenwart. Allgemeine Enzyklopädie der Musik. Kassel 1995, Sp. 967–982

- André Ruschkowski: Soundscapes – Elektronische Klangerzeugung und Musik, 1. Auflage 1990

- Hubert Kupper: Computer und musikalische Komposition. Braunschweig 1970

- Curtis Roads: The Computer Music Tutorial. MIT Press 1996

- Martin Supper: Computermusik. in: MGG – Die Musik in Geschichte und Gegenwart. Allgemeine Enzyklopädie der Musik. Kassel 1995, Sp. 967–982

- André Ruschkowski: Soundscapes – Elektronische Klangerzeugung und Musik, 1. Auflage 1990

- Hubert Kupper: Computer und musikalische Komposition. Braunschweig 1970

- Curtis Roads: The Computer Music Tutorial. MIT Press 1996

- Martin Supper: Computermusik. in: MGG – Die Musik in Geschichte und Gegenwart. Allgemeine Enzyklopädie der Musik. Kassel 1995, Sp. 967–982

- André Ruschkowski: Soundscapes – Elektronische Klangerzeugung und Musik, 1. Auflage 1990

Sinfonie für einen alleinstehenden Mann

Demgegenüber steht in der Kunst des 20. Jahrhunderts zunehmend der Mut zur freien Fläche als Gegenpol zur Angst vor der Leere.

Die Verwendung elektronischer Techniken zum Aufzeichnen, Synthetisieren,

Verarbeiten, und analysieren musikalischer Klänge, ist eine Praxis, die in den

Jahren 1948-1952 entstand.

Die technologischen Mittel und deren künstlerische Verwendungen hat seither

mehrere Revolutionen durchgemacht haben.

Heutzutage wird die meiste elektronische Musik durch Verwendung von Computern.

„Computermusik“, sollte seit ungefähr 2006-2007 jetzt

eigentlich „elektronische Musik mit Computern(Laptops)“

genannt werden.

Die meisten der heute verfügbaren Computermusik-Tools haben Vorläufer in

früheren Generationen von Geräten. Der Computer ist jedoch relativ günstig

geworden und die Ergebnisse der Verwendung sind leicht zu dokumentieren und

nachzuvollziehen.

In dieser Hinsicht ist der Computer das ideale

elektronische Musikinstrument – es ist wirklich schwer

voraus zu sagen, welche zukünftige Technologie ihn

wieder verdrängen könnte aus dieser Position.

Ich liebe elektronische Musik, fange immer mehr an sie zu kennen und mag

eigentlich jedes Genre und ich hatte und habe im Allgemeinen viel mit Computern

zu tun.

Wer lernen will, wie man elektronische Musik von Grund auf macht, beginnt auch

heute noch mit dem ganz bescheidenen Oszillator, geht weiter durch Sampling, FM,

Filterung, Waveshaping, usw. Das nimmt viel Zeit in Anspruch.

Der einfachste Weg ist es, mit vorgefertigte Software diese Techniken

auszuprobieren;

Bei mir liegt der Schwerpunkt auf dem Erlernen der Verwendung von universellen

Computermusikumgebung, um die Software selbst zu realisieren.

Es gibt viele Pakete um das zu verwirklichen Pure Data, Csound, Super Collider,

C++, JAVA, Assembler oder Max/MSP.

Ich liebe Mathematik, Geometrie, Elektronik, Physik, Psychologie

und Programmieren.

Das „Niveau“ der Mathematik die man für elektronische Musik braucht

ist nicht wirklich hoch.

Im Dienste der Computermusik z.B. werden die Bessel-Funktionen,

Chebychev-Polynome, Grenzwertsatz und natürlich Fourier-Analyse und

Gabor Transformation verwendet. Wer will vielleicht auch Quantenphsik und

Biologie.

Musikalisch gesehen braucht man nicht wirklich viel von dem Hintergrund, welcher

im Westen gelehrt wird; insbesondere ist westliche Notenschrift nicht

erforderlich.

Einige elementare Elemente der westlichen Musiktheorie werden verwendet,

wie die temperierte Tonleiter, das A-B-C-System zur Benennung von Tonhöhen und

Begriffe wie „Note“ und „Akkord“.

Auch sollte man mit Begriffen der Musikakustik wie Sinuskurven, Amplitude,

Frequenz und die Obertonreihe usw. keine Probleme mehr haben.

https://www.youtube.com/watch?v=tGITgI2t15Y  Wann und Wieso Computer verwenden??

Wann und Wieso Computer verwenden??  ICST

ICST

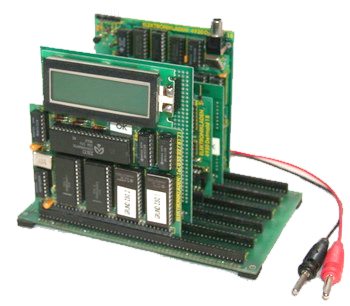

Elektroakustische Musik https://www.youtube.com/watch?v=bKkvFMjw570&feature=youtu.be So um 1975 habe ich angefangen mich mit Computern zu beschäftigen.

kurze Zeit später hatte ich den

NDR-Klein-Computer (kurz NKC) war ein Selbstbauprojekt für einen Computer, welches seit 1984[1] durch die Fernsehsendung ComputerTreff des Bayerischen Fernsehens begleitet wurde. Der Name bezieht sich sowohl auf die Größe, als auch auf den Entwickler des Computers, Rolf-Dieter Klein.

Im Jahre 1984 brachte das NDR-Schulfernsehen unter der Leitung von Joachim Arendt eine 26-teilige Fernsehserie mit dem Titel NDR-Klein-Computer heraus, die je 15 Minuten dauerte.

Die eigentliche Geschichte des elektronischen Schlagzeugs begann Anfang der 1980er-Jahre, als einige Hersteller dem damaligen Synthesizer-Boom folgten und auch das Schlagzeug synthetisieren wollten. Bis dato mussten die einzelnen akustischen Schlagzeugelemente wie Becken, Toms, Snare-Drum und Hi-Hat mit Mikrofonen abgenommen werden, wobei Hintergrundgeräusche oder die akustischen Charakteristika des Raumes ebenfalls mit aufgenommen und verstärkt wurden. Die Hersteller experimentierten mit Triggern, die nicht mehr das Geräusch an sich, sondern nur ein Zeitsignal aufnehmen sollten, um dieses an ein Steuermodul weiterzuleiten, wo es in ein akustisches, analoges Signal umgewandelt wurde. Zur damaligen Zeit lag der Schwerpunkt der Entwicklung darauf, Geräusche zu produzieren, die ein akustisches Schlagzeug nicht hervorbringen kann, wie zum Beispiel Space-Sounds oder Toms mit sehr langem Nachhall. Heute wird eher die möglichst exakte Imitation eines akustischen Instruments angestrebt.

Die eigentliche Geschichte des elektronischen Schlagzeugs begann Anfang der 1980er-Jahre, als einige Hersteller dem damaligen Synthesizer-Boom folgten und auch das Schlagzeug synthetisieren wollten. Bis dato mussten die einzelnen akustischen Schlagzeugelemente wie Becken, Toms, Snare-Drum und Hi-Hat mit Mikrofonen abgenommen werden, wobei Hintergrundgeräusche oder die akustischen Charakteristika des Raumes ebenfalls mit aufgenommen und verstärkt wurden. Die Hersteller experimentierten mit Triggern, die nicht mehr das Geräusch an sich, sondern nur ein Zeitsignal aufnehmen sollten, um dieses an ein Steuermodul weiterzuleiten, wo es in ein akustisches, analoges Signal umgewandelt wurde. Zur damaligen Zeit lag der Schwerpunkt der Entwicklung darauf, Geräusche zu produzieren, die ein akustisches Schlagzeug nicht hervorbringen kann, wie zum Beispiel Space-Sounds oder Toms mit sehr langem Nachhall. Heute wird eher die möglichst exakte Imitation eines akustischen Instruments angestrebt.

Ich glaube so um die 1985 hatte ich mein erstes elektronische drumset mit verschiedenen Erweiterungen. Dass man das wirklich weiterentwickeln kann in ein neues Interaktives System wie heute glaubte ich damals noch nicht.

https://www.youtube.com/watch?v=M3viqsxQuIU

https://www.youtube.com/watch?v=qXJyk0BezA0

https://www.youtube.com/watch?v=wad1bQoo6pI

D

D und, diese module müssen heute nicht wirklich hardware sein. s. reaktor und co!! Vater des NOISE = Lou Reed https://www.youtube.com/watch?v=PB1cEyy0fKs #MOOG

und, diese module müssen heute nicht wirklich hardware sein. s. reaktor und co!! Vater des NOISE = Lou Reed https://www.youtube.com/watch?v=PB1cEyy0fKs #MOOG

ALGORITHMISCHE Revolution

Software ist im Jahre 2020 und früher schon, genauso mächtig, wie die Hardware. Nur wiegt sie weniger!! https://www.youtube.com/watch?v=y9X-qd06nYg

Software ist im Jahre 2020 und früher schon, genauso mächtig, wie die Hardware. Nur wiegt sie weniger!! https://www.youtube.com/watch?v=y9X-qd06nYg

https://ubu.com/film/wilets_electronic.html

Algorithmische Komposition zu Covid 19

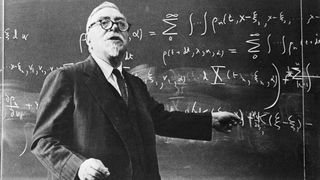

Herbert Eimert war Komponist, Musikwissenschaftler und -journalist. Er hatte in den 1920er Jahren eine Atonale Musiklehre geschrieben, die ihm die Entlassung aus der Kölner Musikhochschule einbrachte (später wurde er dort Professor). Er stand seit seiner Jugend auf der Seite des radikalen musikalischen Fortschritts und veranstaltete Konzerte mit Geräuschinstrumenten.

Eimert wurde der erste Leiter des Studios für elektronische Musik. Werner Meyer-Eppler war Dozent am Institut für Phonetik und Kommunikationsforschung der Bonner Universität. Er hatte 1949 als erster den Begriff „elektronische Musik“ im Untertitel eines seiner Bücher verwendet (Elektrische Klangerzeugung. Elektronische Musik und synthetische Sprache).

So ganz sicher was ich nun mache bin ich mir nicht mehr, aber ich fühle dass ich auf dem richtigen Weg bin!! UM20

https://www.youtube.com/watch?v=JManm091qWI

- um Dinge zu tun, die ich ohne Ihn nicht tun kann.

- der Computer ist eine Art Werkzeug, ein Musikinstrument.

- er unterstützt die Kreativität, den Workflow an vielen Stellen der Arbeit.

- trotzdem: wirkliche Kreativität und Ideen entstehen bei mir mit Bleistift, Papier, Radiergummi und einem klaren Kopf

- weil ich mit ihm alle theoretisch machbare Sounds „kreieren kann – Sounddesign und auc die, die ich mag und nicht mag.

- die Arbeit, die Kunst ist es sehr sehr wahrscheinlich, die richtigen, für mich schönen Sounds zu finden. Das ist es glaube ich, was mich antreibt, das Suchen nach Neuen, Anderen. Schönen. Also eine Frage der Ästhetik. Der Motor für mein wissenschaftliches und künstlerisches Tun,

- und, ganz wichtig: Ich bin gegen eine Akademisierung der Musik.

- ich liebe die Einfachheit. Und es ist für mich etwas sehr Schönes, Sachverhalte so zu vereinfachen, dass ein Jeder es versteht.

- Vorsicht: Man sollte alles so einfach machen wie möglich, aber nicht einfacher!!

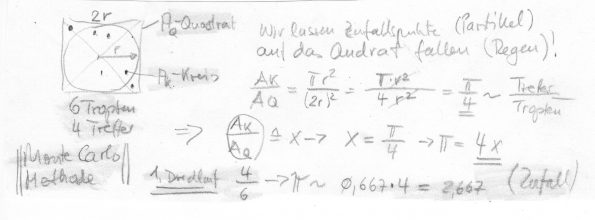

Bild: Monte Carlo Methode als einfachstes Beispiel, wie man Mathematik und Physik gebrauchen kann um Sounds zu erstellen.

- Es ist ein Leichtes, diese Annäherung an die Kreiszahl PI zu programmieren. Egal welche Sprache man benutzt, JAVA, Phython, Assembler, C, CSound, Chuck, Supercollider….

- Hier als Beispel in Pseudocode. Das übersetzen in irgendeine Sprache kann dann ein Jeder tun. Das Problem ist gelöst!!

- Beispiele zu Javascript und MAX auf meiner Youtube Seite.

- Man kann nun dem Regen und der Zahl PI im ersten Versuch verschiedene Sounds zuordnen. Wer will kann sie dann auch nach harmonischen Gesetzen ordnen. Mir persönlich gefällt die Natur des Zufalls besser.

- Mathematik und Computer sind hier Handwerksmittel. Das Interessante für mich ist, wie klingt es selbst, im Vergleich zu anderem, und und…

- welche Emotionen löst es aus bei mir und anderen

- ich sehe die Regentropfen als Partikel, Teilchen an (Quantentheorie) usw. usw.

- ich kann Cluster bilden

- ……eigentlich gibt es keine Grenzen.

und auch wenn ich ein Musikstück daraus bilde, also Form und Rhythmik einbringe, kann es an jedem Tag ganz anderst klingen und wirken.

- man findet immer wieder Neues

Polen und elektronische Musik. Click!!

| M | D | M | D | F | S | S |

|---|---|---|---|---|---|---|

| 1 | ||||||

| 2 | 3 | 4 | 5 | 6 | 7 | 8 |

| 9 | 10 | 11 | 12 | 13 | 14 | 15 |

| 16 | 17 | 18 | 19 | 20 | 21 | 22 |

| 23 | 24 | 25 | 26 | 27 | 28 | 29 |

| 30 | 31 | |||||

- März 2026

- Februar 2026

- Januar 2026

- Dezember 2025

- November 2025

- Oktober 2025

- September 2025

- August 2025

- Juli 2025

- Juni 2025

- Mai 2025

- April 2025

- März 2025

- Februar 2025

- Januar 2025

- Dezember 2024

- Oktober 2024

- September 2024

- August 2024

- Juli 2024

- Mai 2024

- April 2024

- März 2024

- Februar 2024

- Januar 2024

- Juli 2023

- Juni 2023

- Mai 2023

- April 2023

- März 2023

- Januar 2023

- Dezember 2022

- November 2022

- Oktober 2022

- September 2022

- August 2022

- Juli 2022

- Juni 2022

- Mai 2022

- April 2022

- März 2022

- Februar 2022

- Januar 2022

- Dezember 2021

- November 2021

- Oktober 2021

- September 2021

- August 2021

- Juli 2021

- Juni 2021

- Mai 2021

- April 2021

- März 2021

- Februar 2021

- Januar 2021

- Dezember 2020

- November 2020

- Oktober 2020

- September 2020

- August 2020

- Juli 2020

- Juni 2020

- Mai 2020

- April 2020

- März 2020

- Februar 2020

- Januar 2020

- Dezember 2019

- November 2019

- Oktober 2019

- September 2019

- August 2019

- Juli 2019

- Juni 2019

- Mai 2019

- April 2019

- März 2019

- Februar 2019

- Januar 2019

- Dezember 2018

- November 2018

- Oktober 2018

- September 2018

- August 2018

- Juli 2018

- Juni 2018

- Mai 2018

- April 2018

- März 2018

- Februar 2018

- Januar 2018

- Dezember 2017

- November 2017

- Oktober 2017

- September 2017

- August 2017

- Juli 2017

- Juni 2017

- Mai 2017

- April 2017

- März 2017