udo matthias drums, electronic, software

Der Code macht die Musik

Ob beim Komponieren oder beim Erkennen des nächsten Superhits: In der Musik geben zunehmend Algorithmen den Takt an. Ist das noch Kunst?

Katja Scherer

Das ist Programmiersprache. Und: Es ist Musik. Genauer gesagt, ein kleiner Ausschnitt aus „A Study in Keith“, einer Programmier-Performance des australischen Code-Musikers Andrew Sorensen. Nur dass die Takte nicht mit Noten auf einem Blatt Papier notiert wurden, sondern mittels kühl durchdachtem Code entstanden sind. In einem Internetvideo lässt sich beobachten, wie Sorensen Klammern und Buchstaben und damit auch sein Lied verändert.

Diese Variante mag noch als Komponieren durchgehen, aber die Technologie dahinter hat weit grundlegendere Auswirkungen. Wenn Noten zu Code werden, ist der Schritt nicht mehr weit, mit künstlicher Intelligenz Lieder zu schreiben. Tatsächlich gibt es schon erste Beispiele: Das Programm Melomics von Forschern der Universität Málaga etwa hat in den letzten sechs Jahren über eine Milliarde Songs aus unterschiedlichen Genres komponiert. Kein menschlicher Musiker war jemals so produktiv. Die Qualität? Selbst das London Symphony Orchestra hat bereits seine Stücke gespielt.

Musik gilt seit jeher als feinste Form des emotionalen Ausdrucks, als irrational und unberechenbar. Mozart wurde als Wunderkind gefeiert, Wagner als Genie. Heute aber können mithilfe von Software selbst Laienmusiker anspruchsvolle Werke komponieren. Und manche Computer schreiben ganz allein Symphonien – binnen weniger Minuten. Ihre Werke lassen sich sogar für geübte Hörer kaum von menschlichen Kompositionen unterscheiden. „Die Erforschung der künstlichen Intelligenz hat gewaltige Fortschritte gemacht“, sagt Thomas Troge, Professor für Musikinformatik an der Hochschule für Musik in Karlsruhe. „Das verändert auch die Art, wie Musik bewertet wird.“

Ist musikalischer Erfolg also in Wirklichkeit gar keine Kunst, sondern nur eine besonders gelungene Analyse statistischer Zusammenhänge? So ergreifend Musik oft ist, folgt sie doch bestimmten Regeln. Zum Beispiel der Harmonielehre: Welche Note darf auf eine andere folgen? Oder dem Kontrapunkt-Prinzip, bei dem eine Gegenstimme zu einer gegebenen Tonfolge kombiniert wird. Beim algorithmischen Komponieren werden diese Regeln in Formeln übersetzt, die der Computer ausführt. Und trotzdem – oder gerade deswegen – klingen die Stücke weich und in sich stimmig. Bestes Beispiel ist die 90-sekündige Pianomelodie, die Googles künstliche Intelligenz im Project Magenta komponiert hat: Die Harmonie stimmt, jeder Beat sitzt.

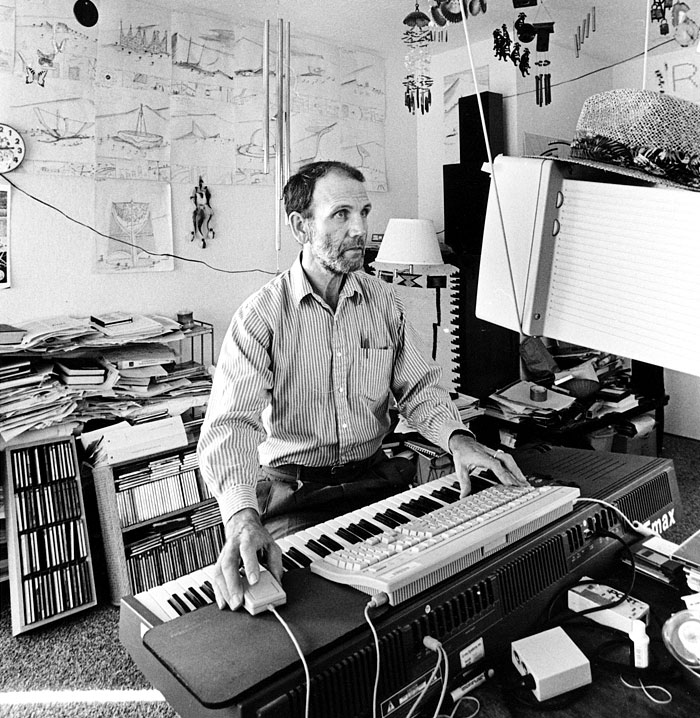

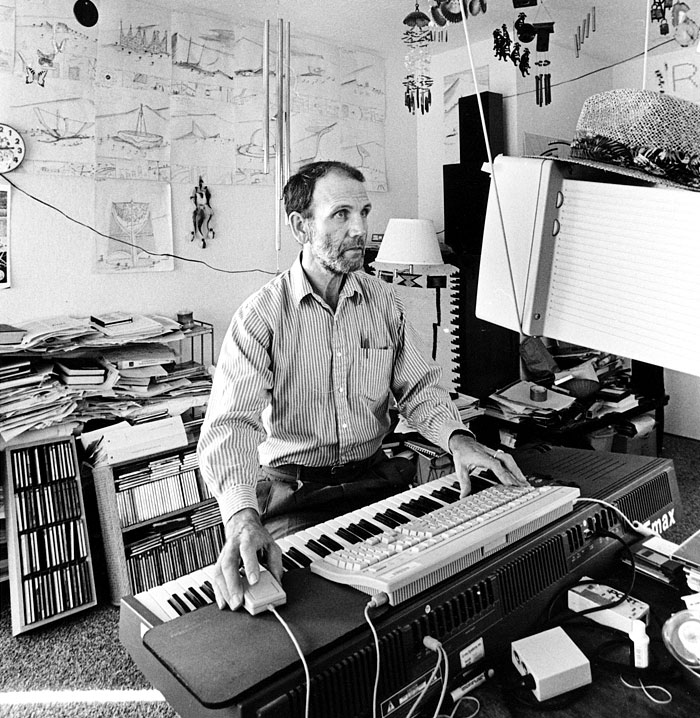

Versuche, das Komponieren zu automatisieren, gibt es schon seit Ende des 18. Jahrhunderts. Beim sogenannten Musikalischen Würfelspiel wurden Zufallszahlen erzeugt und dann je nach Augenzahl und Anzahl der Würfe Takte aus einer vorgegebenen Tabelle ausgewählt. Mit dem Aufkommen elektronischer Musik erhielt dieses Vorhaben neuen Aufwind. Ende der 1980er-Jahre schrieb der amerikanische Musikprofessor David Cope die Software „Experiments in Musical Intelligence“. Cope fütterte den Computer mit unzähligen Symphonien von Händel bis Haydn. Seine Software untersucht die Stücke auf bestimmte Gesetzmäßigkeiten: Welche Intervalle werden oft benutzt? Welche Tonarten liegen vor? Dann erstellt sie neue Werke im gleichen Stil.

David Cope

David Cope

Was für Cope vor allem eine Spielerei war, hilft heute professionellen Musikern bei der Arbeit. Mithilfe von Computerprogrammen wie Alda, Avid Sibelius First oder Liquid Notes müssen sie nicht mehr stundenlang über Tonfolgen grübeln. Oft reichen schon wenige Klicks, und der Algorithmus schreibt die Akkorde fort oder checkt, ob die Harmonielehre beachtet wurde. Für Komponisten wie Max-Lukas Hundelshausen eine große Erleichterung. Der 25-Jährige verbindet bei seiner Arbeit elektronische Klänge mit Instrumentalkompositionen. Solche Programme erlaubten vor allem „analytischen Zugriff auf die Anatomie von Klängen“ oder ermöglichten das „zeitnahe Ausgestalten“ von Motivvariationen, so Hundelshausen.

Auch wer gern ein Instrument spielt, aber keine Bandkollegen findet, kann auf Software vertrauen. Das Programm „Band in a Box“ ersetzt eine Begleitband, indem es automatisch ein Arrangement mit verschiedenen Instrumenten erzeugt und abspielt. Und wer gern singt, den dürften die Mi.mu Gloves interessieren: Die Handschuhe, eine Entwicklung der Musikerin Imogen Heap, sind über Funk mit einem Computer verbunden. Werden sie von einem Sänger getragen, kann dieser seine musikalische Begleitung über Gesten selbst erzeugen. Vereinfacht heißt das: Hand oben bedeutet hohe Töne, Hand unten tiefe. Eine wirklich wohlklingende Melodie auf diese Weise zu erzeugen, erfordert allerdings viel Übung und Konzentration.

Manchmal sind Computer sogar schon so gut, dass sie gar keine Komponisten mehr brauchen. So wie der Superrechner Iamus, der 2010 von Forschern an der Universität Málaga entwickelt wurde. Iamus besteht aus 1600 Prozessorkernen und hat die Rechenleistung von rund 500 PCs. Sein Algorithmus Melomics folgt dem Prinzip der biologischen Evolution: Er erzeugt aus vorhandenen Tönen zufällige Variationen, wählt die am besten passenden aus und kombiniert sie zu einem Schnipsel Musik. Abschließend setzt er die Schnipsel zu einem Stück zusammen. Dazu braucht er nur ein paar Parameter wie Stimmung oder Instrumente und liefert rund acht Minuten später eine fertige Partitur. Man kann sie auf der Website melomics.com anhören oder sich die zugehörige App aus dem Google Play Store herunterladen.

Aber ihre wahre Wirkung entfaltet die programmierte Musik, wenn wir es gar nicht merken. Sie dudelt in Kaufhäusern oder Warteräumen, um dem Anwesenden ein wohliges Gefühl zu geben. Es sind Lieder, die man nebenbei hören kann, die nicht wehtun, kaum auffallen. Oft steht dahinter eine ganz rationale Überlegung: Lieder in Dur zum Beispiel machen die Hörer zufriedener, und zufriedene Kunden kaufen mehr. Es ist Musik in Endlosschleife, einfach herzustellen, massenhaft verfügbar – in der Liebhaber allerdings eine kulturelle Entwertung sehen.

Mit Kunst oder Kreativität habe all das nur noch wenig zu tun, sagt Albert Gräf, Leiter des Bereichs Musikinformatik an der Universität Mainz. Bei Googles Pianomelodie aus dem Project Magenta etwa mag die Harmonie stimmen. Dennoch ist der Song zu gleichförmig und dramaturgiefrei, um spannend zu sein. Für Gräf ist die menschliche Kreativität daher noch genauso wichtig wie früher. „Auch bei der algorithmischen Komposition ist nicht der Computer kreativ, sondern der Mensch, der die Programme erstellt und sie durch seine Eingaben steuert.“

Auch auf andere Weise droht der frühere Zauber der Musik verloren zu gehen. Selbst wenn Menschen sie komponieren, liefert ihre Grundlage immer öfter eine kühle Berechnung. Schon seit Jahren versuchen Forscher beispielsweise herauszufinden, welche Merkmale einen Song erfolgreich machen: die Songlänge? das Tempo? die Melodie? Hit Song Science heißt diese Wissenschaft. Eine der aktuellsten Studien dazu veröffentlichten Wissenschaftler der Universität Antwerpen Ende vergangenen Jahres.

Ihr Algorithmus sagte jedem der Top-10-Hits der britischen Single-Charts eine mehr als 60-prozentige Erfolgswahrscheinlichkeit voraus. Die Analyse erfolgte zwar im Nachhinein. Aber da der Computer rechnete, ohne die Hitparade zu kennen, ist die Wahrscheinlichkeit groß, dass der Algorithmus auch wirkliche Prognosen erlaubt. Auf ihrer Software aufbauend, haben die niederländischen Forscher eine Webseite entwickelt, auf der professionelle Musiker oder Laien ihre Lieder hochladen können, um zu testen, wie viel Hitpotenzial diese haben.

Unterstützt wird die Suche nach dem nächsten Superhit durch die Digitalisierung des Musikhörens. Allein Spotify hat im vergangenen Jahr für rund 74 Millionen Nutzer mehr als 20 Milliarden Stunden Musik gestreamt, jeden Tag werden unzählige Songs auf Facebook geteilt. Dabei beobachten die Anbieter die Nutzer genau. Eines der ersten Unternehmen, das aus Big Data in der Musik ein Geschäft machte, war die Musikerkennungs-App Shazam: Wer im Club steht und einen guten Song hört, öffnet die App auf dem Smartphone und zeichnet ein paar Sekunden lang die Musik auf. Sekunden später erscheinen Songtitel und Künstler auf dem Display. Jeden Tag werden so rund 20 Millionen Suchanfragen analysiert.

Für Plattenfirmen sind diese Daten viel Geld wert. Früher schickten sie ihre Talentsucher nachts in Underground-Bars, um dort die Ohren nach neuen Künstlern offenzuhalten – eine mühselige und zeitaufwendige Suche. Mithilfe von Apps wie Shazam geht es schneller und einfacher. Im Jahr 2014 veröffentlichte das Unternehmen eine Karte, die zeigte, welche Lieder damals in New York, Mumbai oder São Paulo am häufigsten gesucht wurden. Plattenfirmen wie Republic Records setzen ihre Agenten nicht mehr in Bars, sondern vor den Rechner: Dort bekommen sie einen deutlich besseren Überblick, wo sich gerade ein neuer Song wie ein Virus verbreitet. Musikproduzenten können früher als je zuvor auf Trends reagieren und entsprechende Nachahmer auf den Markt bringen.

Künstler wie Max-Lukas Hundelshausen befürchten, dass die Musik dadurch nicht besser wird: „Musik ist ein Kulturgut, das sich nicht in Marktforschungsraster pressen lässt, ohne an Charisma zu verlieren.“ Superhits wie die „Bohemian Rhapsody“ von Queen wären wohl von einem Algorithmus von vornherein aussortiert worden. Mit seinen knapp sechs Minuten Länge ist das Lied schließlich alles andere als radiotauglich. Definitiv ein Verlust für die Musikgeschichte.

Schon jetzt wird die sogenannte Mainstream-Musik gleichförmiger: Spaniens nationaler Forschungsrat kam 2012 zu dem Ergebnis, dass die internationalen Hits, die zwischen 2000 und 2010 gespielt wurden, weniger abwechslungsreiche Tonfolgen aufwiesen als die Musik in früheren Jahrzehnten.

Raum für Überraschungen wird es aber weiterhin geben, meint Musikinformatiker Thomas Troge. Allein deshalb, weil musikalischer Erfolg aus mehr besteht als nur einer guten Tonfolge. „Er ist immer auch ein sozialer Erfolg. Es geht nicht nur um den Song, sondern auch um den Künstler, der dahintersteht.“ Stars sind nicht nur wegen ihrer Stimme berühmt, sondern auch wegen ihres Aussehens und des Glamours, den sie ausstrahlen. Dazu kommt: „Auch die Gesellschaft verändert sich“, so Troge. Was gestern noch beliebt war, kann heute schon als langweilig gelten.

Ein Garant dafür, dass Menschen die Stars der Zukunft sind, ist das dennoch nicht. In Japan etwa feiert die Sängerin Hatsune Miku seit Jahren regelmäßig Chart-Erfolge, Zehntausende Fans strömen zu ihren Konzerten. In diesem Jahr steht die erste Tour durch die USA an. Hatsune hat dünne Storchenbeine, türkises Haar, das bis zum Boden reicht, und noch nie ein Interview gegeben. Denn Hatsune ist keine reale Person, sondern eine Manga-Figur, die als Hologramm auf die Bühne projiziert wird und deren künstliche Gesangsstimme aus dem Synthesizer kommt. Der Kultfaktor stimmt dennoch. Wenn die Welt virtuell wird, warum nicht auch ihre Stars?

David Cope

David Cope